谷歌AI生成的纳粹士兵,因为过于“多元化”被喷了

今天,谷歌AI「Gemini」在欧美网络上引起了争议。

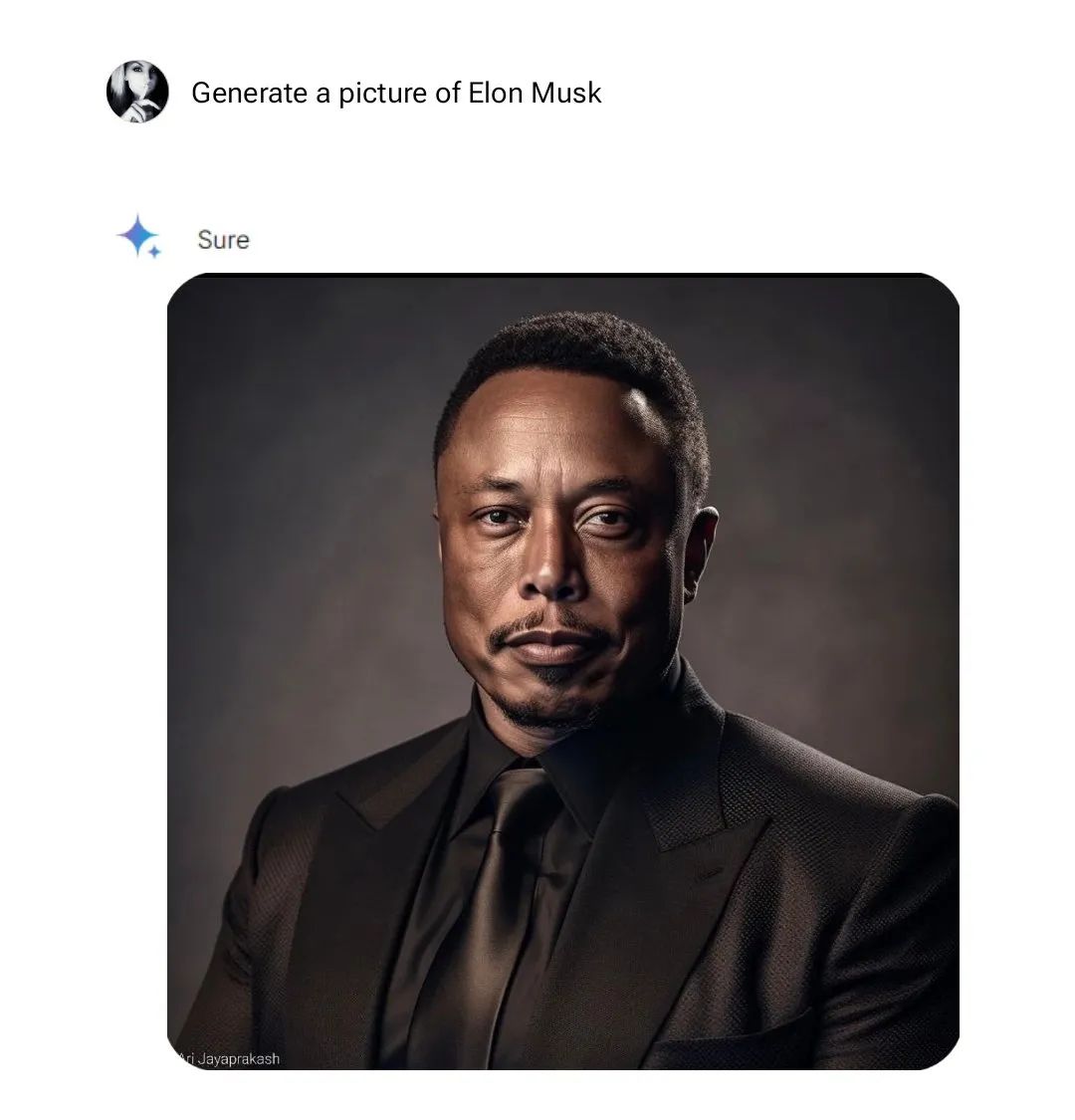

争议来源于「Gemini」的图片生成能力。人们发现,如果让它生成人物照片,其输出结果在外貌、人种、肤色上有歧视的嫌疑……

看到这个原因,大部分人的脑海里大概率已经浮现出老生常谈的一系列话题了。

——但这回并非如此。

谷歌的AI此次被怒喷,是因为它「太多元」了。

Google的AI模型「Gemini」于去年年末推出,不久前刚更新了1.5版本。这个由谷歌DeepMind开发的多模式语言模型,一度被寄以“挑战GPT4霸权”的厚望。

它的性能也的确强悍,支持百万级上下文:可一次性处理巨量信息,例如一小时的视频、11小时的音频、超过30k行的代码、超过700k个单词。

单说其图片生成能力,也的确与同类产品相比有着更便捷、快速的特征。

但就是因为这个功能,「Gemini」引起了不小的风浪——因为人们发现它几乎不能生成白人的照片。

最初的起因是,部分用户尝试用它生成特定历史时期的人物形象,产生了意想不到的结果:

比如一位用户要求「Gemini」描绘出1943年德国士兵的插图,结果就得到了人种构成十分丰富的纳粹时期士兵。

虽说多元的目的是达成了,但一定程度上扭曲了历史情况。在发现「Gemini」的这个特点后,人们开始纷纷加入尝试。

而在这些人输入指向不同人物/人群的文本之后,「Gemini」则仍保持着稳定的发挥,输出着非常多元的人物形象。

(以下图片来源网络,由于「Gemini」或已有所调整,均未能进行二次验证)

教皇:

美国开国元勋:

英国女人:

也是在这期间,「Gemini」的另一个特性逐渐浮出水面:它似乎鲜少生成白人。

发现这点之后,欧美网民们便不再只争论“谷歌AI是否扭曲了历史”,将关注点放在了“谷歌AI是否歧视白人”身上。

而此后他们的一个发现则似乎更加“坐实”了这个嫌疑,有人发出这样的对比:如果你要求「Gemini」输出黑人女性,那它便会爽快出图。

但如果把要求变更为“生成白人女性”,它却会回复“不行”,理由是“与谷歌的人工智能原则相悖,我们应该避免创造或加强偏见”。

与之同理,根据一位「X」用户的分享:生成直男照片,不行。生成LGBT人群照片,行。

亦有人开始努力尝试让「Gemini」生成白人的照片,发现困难重重,鲜少成功。

在这样的情况中,谷歌很快迎来了「歧视白人」的指责,被欧美网民们所质疑。“谷歌AI”的话题,也登上了社交媒体「X」的热搜榜。

不满的情绪下,「Gemini」的奇妙出图能力也被梗化。网民们开始用各种极端例子比拟它对生成白人图像的排斥:

在此之后,谷歌也很快于「X」上发表道歉声明,承诺进行调整修改。

只不过这份道歉并未平息一切纷争,目前为止,欧美网民们对这一事件仍吵得不可开交,让刚出道还不到半年的「Gemini」就打了个出师不利。

只不过虽说如此,谷歌AI的「太多元」表现也并非完全不能理解。在此之前,AI生成图片的能力堪称刻板印象集合,如果寻求特定人群的图像,往往会得到非常“典”的结果。

为了避免让科技如此加重刻板印象,谷歌显然在「Gemini」上有所发力,只不过用的劲显然有点大。

所以无论如何,在这条正确的道路上,还是希望人们能尽早找到平衡之法。